AI 的「iPhone 时刻」已经到来

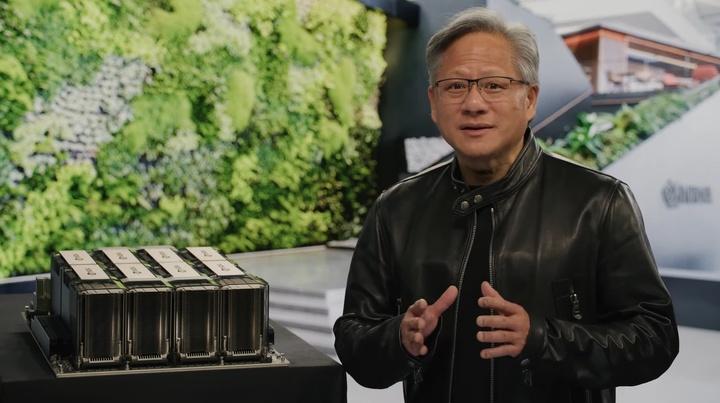

在刚结束的英伟达 GTC 2023 大会上,英伟达 CEO 黄仁勋把这个观点反复说了 3 遍。

怎么理解?

iPhone 搭载的多点触摸屏幕技术开创了一个全新的智能手机界面交互模式,由此孕育了移动互联网。

而 ChatGPT、Stable Diffusion 等 AI 超级应用的出现,标志着加速计算和 AI 技术的成熟已迈入成熟,AI 正以一个前所未有的速度渗入各行各业,推动一场新的产业革命。

经过近几年 AI 技术的不断发展,强大算力和先进模型为 AI 提供了合适的应用平台,促使各个厂商们重新构想自己的产品和商业模型,以及更新迭代的速度。

昨天晚上,英伟达、微软、Google、Adobe 等厂商在相差无几的时间里都推出了各自的 AI 服务,你追我赶之势仿佛在传达着同一个焦虑:

「在这个大 AI 时代,如果不想被人颠覆,就要先颠覆别人。」

AI 将会怎样改变我们的生活?看过这「AIGC 最卷一夜」后,你或许能有更深的感触。

英伟达正在把 AI 带到各行各业

英伟达在一年一度的 GTC 大会上又带来了很多让人眼前一亮的「新活」。

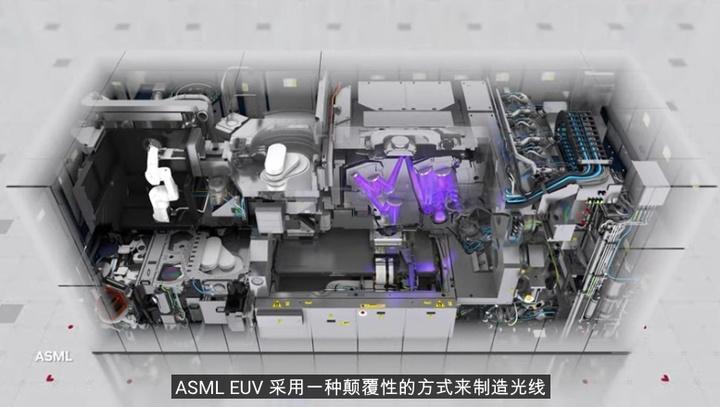

例如发布了一项名为 CuLitho 的 AI 辅助制芯技术,为 2nm 制程铺平了道路;与路特斯、奔驰、宝马等汽车厂商合作,用 Omniverse 搭建数字生产线等。

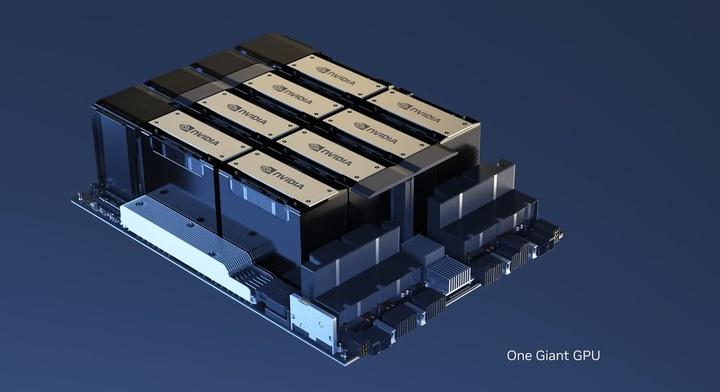

但要说到整场 GTC 大会最亮眼的内容,还得是英伟达发布的新显卡——带有双 GPU NVLink 的 H100 NVL。

H100 NVL 是专门针对算力需求巨大的 ChatGPT 而设计的显卡,H100 NVL 拥有夸张的 188GB HBM3 内存(每张卡 94GB),这也是目前英伟达发布的内存最大的显卡。

像 GPT 这样的大语言模型非常占用内存资源,理论上参数达到上千亿的 GPT 模型可以迅速占满一张 H100 显卡。

与用于 GPT-3 处理的 HGX A100 相比,使用了四对 H100 和双 GPU NVLink 的标准服务器的速度快了 10 倍,「核弹级」的 H100 NVL 是大规模部署像 ChatGPT 语言模型的理想选择。

英伟达整的另一个大活就是把「ChatGPT 同款」搬到了云上,向公众开放。

ChatGPT 的运行主要依靠由 A100 或 H100 组成的 DGX 超级计算机,微软为此花了数亿美金采购了上万张 A100 显卡组建 Azure 云计算平台。

为了降低用户部署大模型的成本,英伟达推出了 DXG Cloud 服务,每个月 36999 美元起,你就能获得一个由 8 张 H100 或 A100 显卡组成的云端超级计算机,轻松完成高负载的计算工作。

2016 年,老黄亲手向 OpenAI 交付了第一台 DGX 超级计算机电脑。7 年之后,顶尖的 AI 算力通过 DXG Cloud 有机会走进每家公司,完成在过去不可能完成的任务。

不难想象,像 ChatGPT 这样能够改善人类交流、提高工作效率的先进应用会持续涌现,为我们的生活带来更多的便利和惊喜。

点石成金,二代 Runway 让你一句话生成各式大片

B 站一直流行一句梗:视频不能 P,所以这是真的。但如今视频不仅可以 P,还可以从无到有直接用 AI 生成,不用画师、不用摄影、不用后期。只要你往 Runway 中输入一段文字,它便还你一段震撼人心的短片。

最早,Runway 是一款后期辅助工具,虽然借助了人工智能的神奇力量,但所能实现的,并不复杂:擦除物体、图像插帧、删除背景、运动追踪等,可以将它视作 Adobe Premiere 的傻瓜式插件。

而当 Runway 打开人工智能的新大门后,它拥有了点石成金的能力。在去年 9 月公布的 Gen 1 版本中,它有了文本转视频的能力。那时的人们,刚刚见识过文本转图像的魔力,而 Runway 直接能生成动态影像,简直是降维打击般的震撼。

时隔半年,Runway Gen 2 来了。