回顾2022年,出圈次数最多,引起人们讨论最广泛的技术应用非人工智能生成内容(AIGC)莫属。

年中,AI画作《太空歌剧院》在科罗拉多州博览会艺术比赛中一举夺魁,引起了人们对AI创作合理性的激烈讨论。

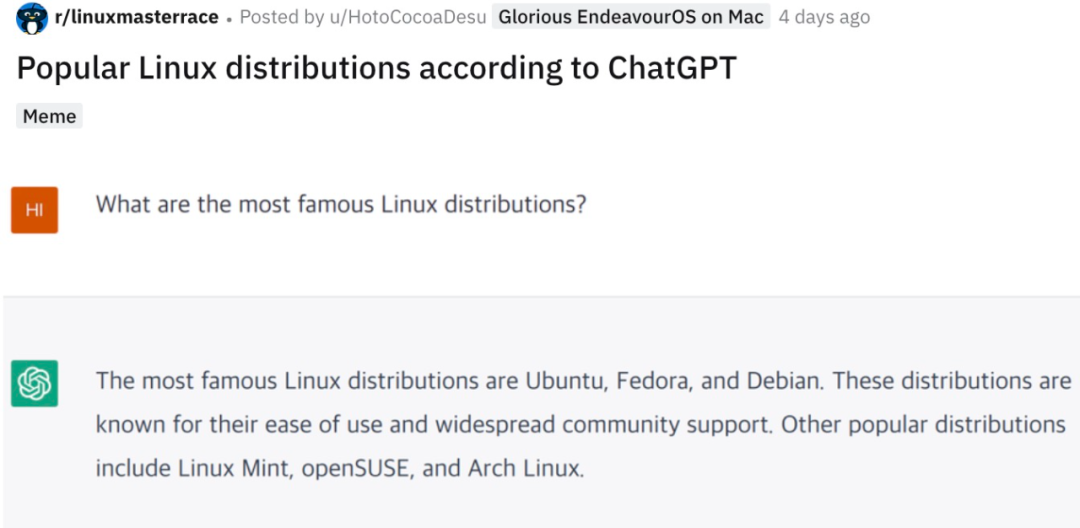

年末,ChatGPT横空出世,技惊四座,出色地回答了人类提出的各种问题,让许多人感叹“这是我见过最像AI的AI”,掀起了与人工智能对话的热潮。

而在今年的百度AI开发者大会中,百度技术委员会主席吴华介绍了文心大模型的视频内容生成与编辑技术,让一言化视频成为了现实,赋予了每个人都能成为制片人的机会,引起了人们的广泛关注。

在这多次爆火出圈的背后,真正让人感叹的其实是人工智能技术的飞速发展。那么,AIGC的发展到底经历了哪些阶段,为何集中于2022年“井喷”式爆发?我们的生活又将怎样被AIGC改变?立足当下,AIGC行业的发展状况又是如何呢?

1

AIGC的万千“面孔”

历经数十年发展,深度学习模型不断迭代,AIGC迎来突破性发展。

在各类使用AIGC技术的应用大规模“井喷”之前,AIGC也曾经历了几十年的发展。结合人工智能的演进沿革,AIGC的发展历程大致可以分为三个阶段:早期萌芽阶段、沉淀积累阶段、快速发展阶段:

在早期萌芽阶段(1950s-1990s),受限于当时的科技水平,AIGC仅限于小范围实验。1966年,约瑟夫·魏岑鲍姆和肯尼斯·科尔比开发了世界第一款可人机对话的机器人Eliza。80年代中期,IBM创造了语音控制打字机Tangora。

在沉淀积累阶段(1990s-2010s),AIGC从实验性向实用性逐渐转变。2006年,深度学习算法、图形处理器、张量处理器等都取得了重大突破。2012年,微软公开展示了一个全自动同声传译系统,可以自动将英文演讲者的内容通过语音识别、语言翻译、语音合成等技术生成中文语音。

在快速发展阶段(2010s至今),深度学习模型不断迭代,AIGC获得快速突破性发展。2014年,对抗生产网络GAN出现。2021年,CLIP模型出现;OpenAI推出DALL-E,主要应用于文本与图像交互生成内容。

而在2022年,深度学习模型Diffusion扩散化模型的出现,更是直接推动了AIGC技术的突破性发展,许多基于StableDiffusion模型的应用纷纷入局,也正因如此,2022年出现了AIGC应用“井喷”现象,也被称为AIGC元年。

国际大厂纷纷入局,诸多行业正在被重新定义。

在AIGC的落地应用中,仅有先进的算法模型远远不够,还需要厂商完成场景化的应用开发。目前,谷歌、Meta、微软等国际互联网大厂早已入局,用AI实力及技术应用推动AIGC的风潮席卷了全球,正重新定义着诸多行业。

在世界范围内AIGC应用如火如荼的发展之下,百度、腾讯、阿里、字节跳动、网易等国内大厂也纷纷跟进,在AIGC领域内动作频频。但要说起谁更能代表中国AIGC的发展,必然当百度莫属。

百度基于在深度学习平台、大模型上等底层技术上的积累,以及对人工智能发展趋势的前瞻性布局,抢占先机,成为全球AIGC发展领导者之一。目前,百度研发的文心大模型已经凭借其强大的内容生成能力,极大地推动了AIGC的发展:

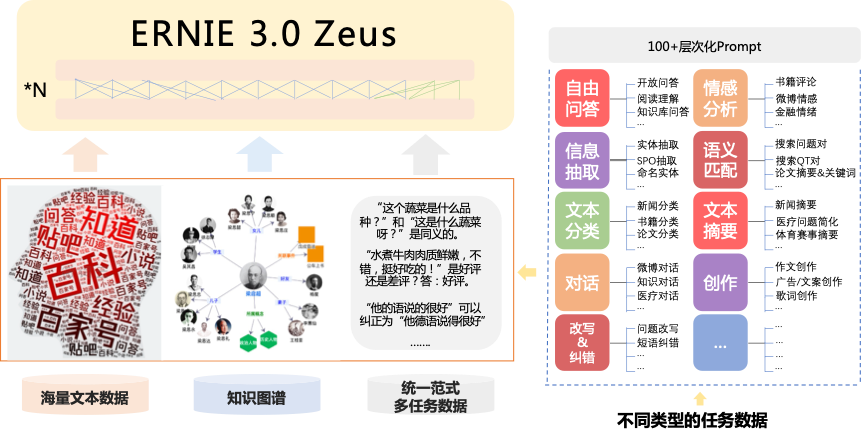

文心大模型中的ERNIE 3.0 Zeus,让每个人都能成为天才编剧。想要成为天才编剧,就一定要具备强大的学习能力,而文心能从丰富多样的无标注数据中自主学习,同时在学习的过程中融入知识图谱,大幅提升学习效率。还可以跨越不同的形式,进行知识的储备、融合,胜任多种语言理解和生成任务,成为了一个名副其实的“通才”。

除了作为一个优秀的学习者、创作者之外,文心大模型还可以胜任美术师、插画师的工作。文心大模型中的ERNIE-ViLG 2.0使用了扩散模型,引入了语言、视觉等多源知识,并在多个阶段选择不同网络来进行建模,实现了能根据一句话或者一段描述文本生成一幅精美的画作的要求。

穿着西装的齐天大圣,图源:文心一格

在静态的文字与画作外,制作动态的视频对文心来说也是小菜一碟。文心大模型可在文生图的基础上通过添加时序建模的方法更进一步,使得模型能根据文本或者图像生成新的视频,而且可根据需求,调节生成视频片段的时长,提升视觉内容生产效果和效率,实现文生视频、文剪视频、修复视频的功能。

2

百度的AIGC“答案”

在国外,谷歌、Meta、微软积极布局,在AIGC领域做得风生水起,让人们看到了人工智能生成内容的前景。而在国内AIGC领域,综合技术水平与应用向的丰富性,行业第一非百度莫属。

每年,百度总会在举办AI开发者大会的时候发布最新技术进展,而这,也是观察国内AI产业发展状况的最好窗口之一。

在今年百度的Create暨AI开发者大会上,介绍的各项技术让人眼前一亮,将AI的应用提升到了一个新高度:

人工智能走向千行百业,“深度学习+”已成各领域推动创新发展新引擎。

伴随着算法、算力、数据的不断发展,深度学习技术及产业应用也正在发生着巨大的变化。从深度学习技术的兴起,到产业链的形成,再到深度跨界融合,深度学习已经进入了一个全新的发展阶段——“深度学习+”。

从技术角度看,深度学习+海量知识,推动了人工智能技术创新突破。通过让机器在海量数据与大规模知识中学习的方法,可以不断提高AI学习效率,完善模型效果,实现创新突破,最终能更好地帮助人类完成工作。举例来说,“文心一格”便是通过知识增强跨模态大模型,通过从语言、视觉等知识中不断融合学习,最终实现“一言成画”功能的。

从生态角度看,深度学习+上下游产业,助力形成完整产业链。目前,深度学习已经在芯片、框架、模型及应用层面形成了深度学习完整的产业链。在芯片层面,成功推动了软硬件一体化;在框架层面,提供便捷开发、高效训练、全域部署的能力;在模型层面,大幅降低产业应用成本;在应用层面,催生了一批新业态模式。四大层级共同拥抱深度学习,实现整个产业链的持续迭代优化。

从产业角度看,深度学习+千行百业,有助于形成全产业良性循环。我国拥有门类齐全、体系完整且规模庞大的产业体系,深度学习驱动的创新,在中国拥有更加丰富的应用场景,也有助于各行业形成良性循环,促进底层技术突破,加快现代产业化产业体系。

目前,人工智能已经进入了“深度学习+”的新阶段,未来,人工智能技术引领的新一轮科技革命和产业变革浪潮,将成为未来世界经济和高端产业的主导技术,对中国现代化产业体系建设发挥无可替代的作用。

用大模型驱动搜索进化的“知一”、“千流”。

搜索作为互联网用户的刚需,是最核心的基础应用,随着人们搜索需求的升级,搜索技术也在越来越快速地演进与发展,而百度将AI与搜索技术融合升级,推出了两项杀手锏技术——跨模态大模型“知一”、新一代搜索引擎“千流”。

跨模态大模型“知一”,助用户搜索内容更精确。

“知一”作为百度推出的跨模态大模型,具有业界领先的超大语义理解能力与全网视频文本理解能力,可以在文本、图片、视频和结构化信息中持续进行海量知识资源的学习收集,打破资源形态界限,将最满足用户的搜索结果呈现出来。

其次,“知一”基于软硬一体的定制硬件,通过百度自研的模型压缩和预估优化技术,实现了近乎无损的大模型落地;另外,“知一”还依托飞桨高性能并行训练框架与百度昆仑芯片,构建了业绩领先的大规模预训练技术。两者共同解决了搜索所需算力规模极大、推理能力极强的问题,为用户提供更加快速、精确的搜索服务。

新一代搜索引擎“千流”,让搜索更高效、更快速。

搜索所需要处理的数据规模特别大,但又需要在毫秒之间完成整个过程,在数千亿的资源中最快速地找到最满足用户需求的内容,传统搜索引擎建立了强大的分布式系统,通过算力的堆积完成任务,但该方法性能消耗巨大,同时搜索内容不充分,某些优质内容无法呈现给用户,已不再适应当前的时代。

而新检索系统“千流”,依托于大模型对的内容深度理解,将不同维度的信息进行智能有序的组织,将传统索引升级为多领域多维度表达的立体栅格化索引, 同时通过模型对每一个请求进行分析,实现千亿分领域内容深度触达,在不消耗巨量算力的前提下,更快速地找到所需内容。

展望2023,立足于大模型产业化应用的元年,提高产业效用、跑通技术提升与经济增长的循环,或许远比实现某个新技术的落地应用更加重要。

而在大会中,百度创始人、董事长兼CEO李彦宏便进行了名为“创新驱动增长,反馈驱动创新”的演讲,讲述了百度在经营发展中,客户端与技术端如何相互促进,推出优秀产品的实践经验,人工智能技术的发展,进一步打通了这个循环。

“科技创新驱动了大的增长,外部反馈又驱动了科技创新”,李彦宏如是说。

而在这一循环中,人工智能技术的发展,便是大大拉近了科技创新与增长之间的距离。

以百度飞桨为例,目前已经凝聚了超五百万开发者,服务于二十余万家企事业单位。通过百度自研的深度学习框架,让开发者能够像搭积木一样构建AI应用,大大降低AI的应用门槛,让创新持续发生,进而促进顶层的商业更加繁荣。

在演讲末尾,李彦宏还以“危机和希望”为关键词,在百度AI作画平台一格上,由人工智能自动生成了这样一幅画,以鼓励所有的参会者。

“生机勃勃的新生命已经破冰而出,然而寒冷还没有完全褪去所有伟大的企业、伟大的创造者也是一样,没有一帆风顺,只有不断地历经困难再凯旋。困难会刺激创新,而创新是增长的真正动力。”