【新智元导读】OpenAI又双叒叕有新整活了!难懂的GPT-2神经元,让GPT-4来解释。人类看不懂的AI黑箱,就交给AI吧!

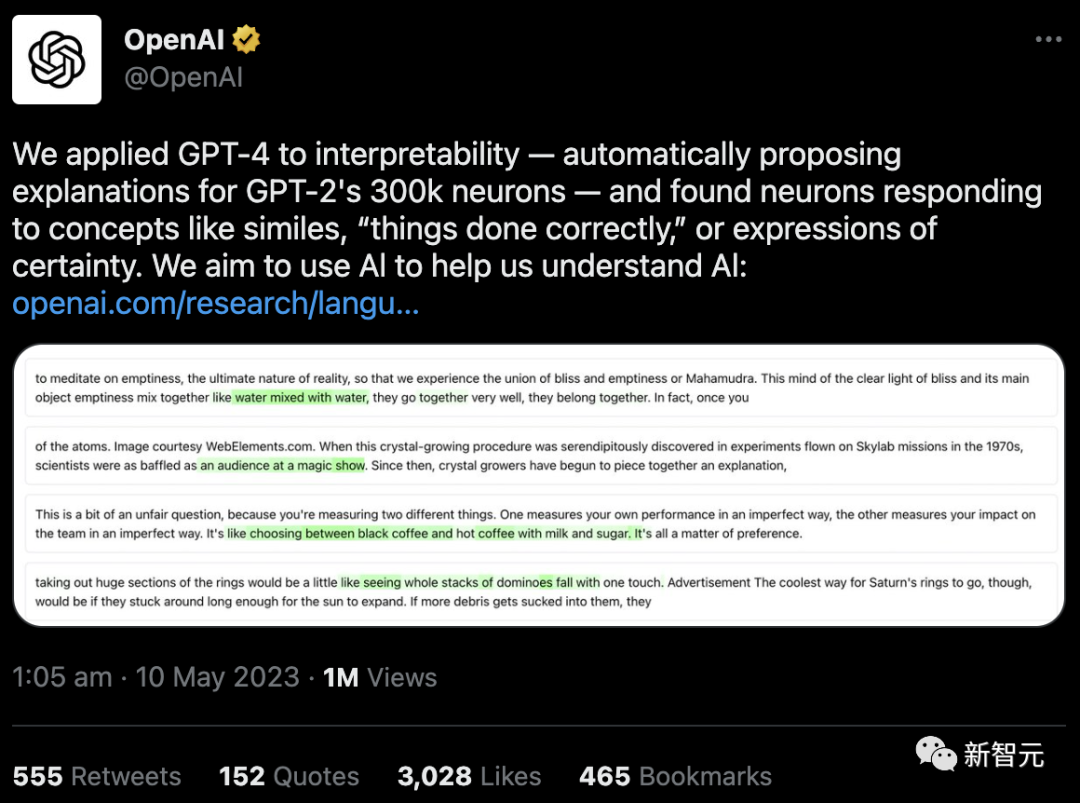

刚刚,OpenAI发布了震惊的新发现:GPT-4,已经可以解释GPT-2的行为!

大语言模型的黑箱问题,是一直困扰着人类研究者的难题。

模型内部究竟是怎样的原理?模型为什么会做出这样那样的反应?LLM的哪些部分,究竟负责哪些行为?这些都让他们百思不得其解。

万万没想到,AI的「可解释性」,竟然被AI自己破解了?

网友惊呼,现在AI能理解AI,用不了多久,AI就能创造出新的AI了。

就是说,搞快点,赶紧快进到天网吧。

GPT-4破解GPT-2黑箱之谜

刚刚,OpenAI在官网发布了的博文《语言模型可以解释语言模型中的神经元》(Language models can explain neurons in language models),震惊了全网。

论文地址:https://openaipublic.blob.core.windows.net/neuron-explainer/paper/index.html#sec-intro

只要调用GPT-4,就能计算出其他架构更简单的语言模型上神经元的行为。

GPT-2,就这样被明明白白地解释了。

要想研究大模型的「可解释性」,一个方法是了解单个神经元的具体含义。这就需要人类手动检测神经元,但是,神经网络中有数百亿或数千亿个神经元。

OpenAI的思路是,对这个过程进行自动化改造,让GPT-4对神经元的行为进行自然语言解释,然后把这个过程应用到GPT-2中。

这何以成为可能?首先,我们需要「解剖」一下LLM。

像大脑一样,它们由「神经元」组成,它们会观察文本中的某些特定模式,这就会决定整个模型接下来要说什么。

比如,如果给出这么一个prompt,「哪些漫威超级英雄拥有最有用的超能力?」 「漫威超级英雄神经元」可能就会增加模型命名漫威电影中特定超级英雄的概率。

OpenAI的工具就是利用这种设定,把模型分解为单独的部分。

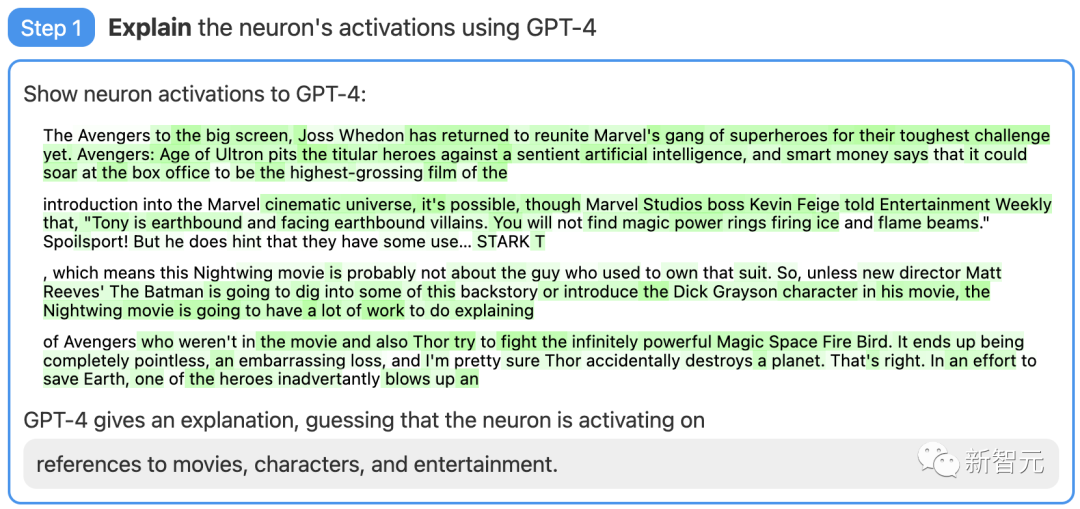

第一步:使用GPT-4生成解释

首先,找一个GPT-2的神经元,并向GPT-4展示相关的文本序列和激活。

然后,让GPT-4根据这些行为,生成一个可能的解释。

比如,在下面的例子中GPT-4就认为,这个神经元与电影、人物和娱乐有关。

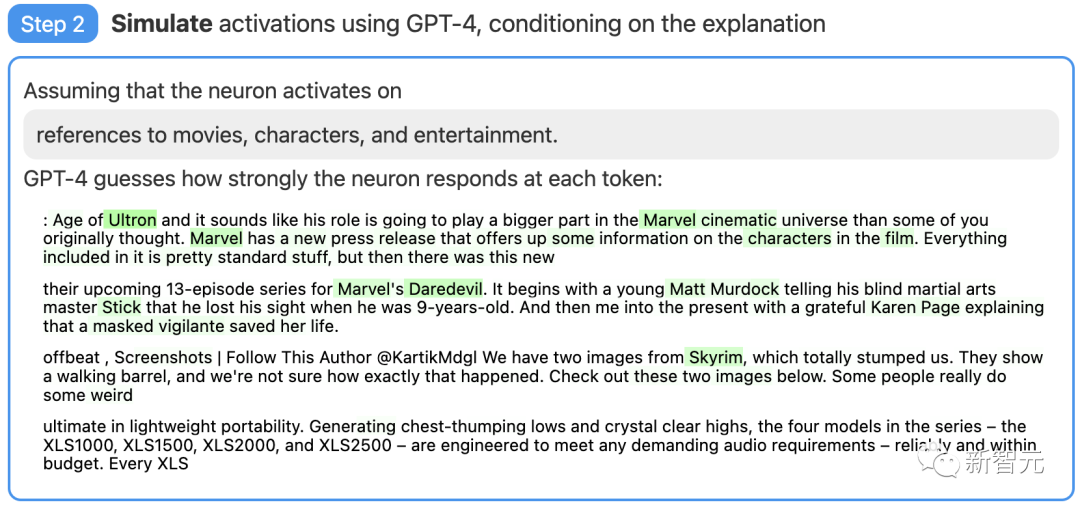

第二步:使用GPT-4进行模拟

接着,让GPT-4根据自己生成的解释,模拟以此激活的神经元会做什么。

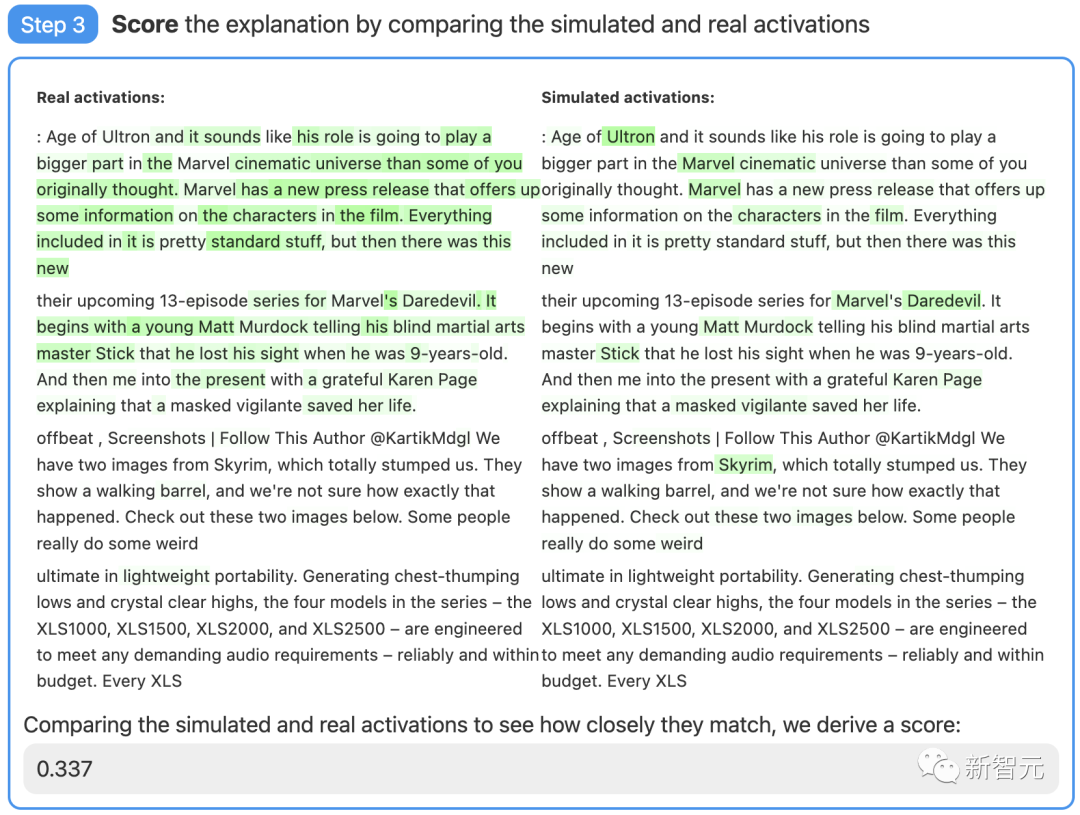

第三步:对比打分

最后,将模拟神经元(GPT-4)的行为与实际神经元(GPT-2)的行为进行比较,看看GPT-4究竟猜得有多准。

还有局限

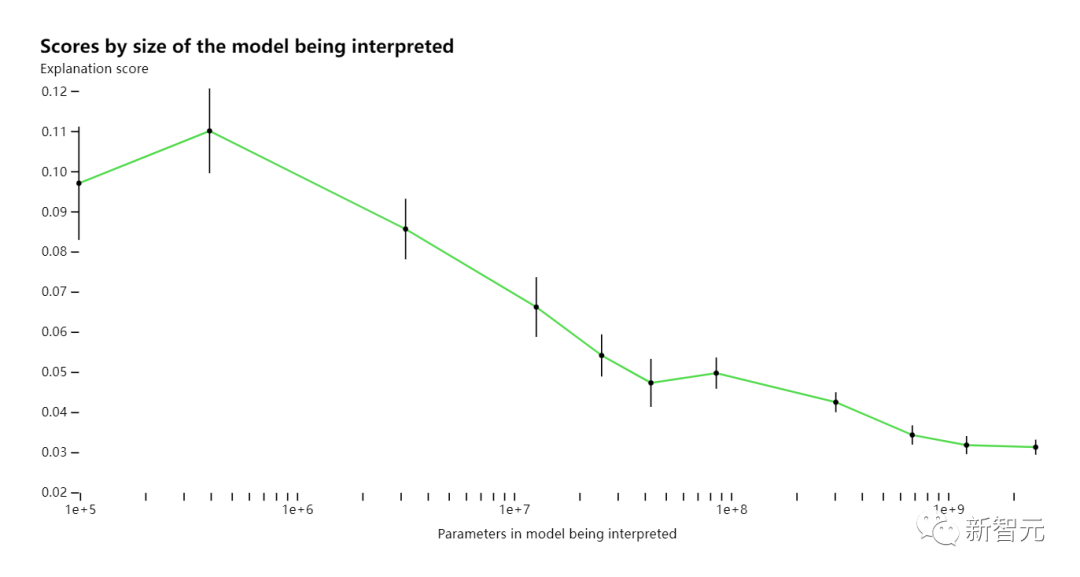

通过评分,OpenAI的研究者衡量了这项技术在神经网络的不同部分都是怎样的效果。对于较大的模型,这项技术的解释效果就不佳,可能是因为后面的层更难解释。

目前,绝大多数解释评分都很低,但研究者也发现,可以通过迭代解释、使用更大的模型、更改所解释模型的体系结构等方法,来提高分数。

现在,OpenAI正在开源「用GPT-4来解释GPT-2中全部307,200个神经元」结果的数据集和可视化工具,也通过OpenAI API公开了市面上现有模型的解释和评分的代码,并且呼吁学界开发出更好的技术,产生得分更高的解释。

此外,团队还发现,越大的模型,解释的一致率也越高。其中,GPT-4最接近人类,但依然有不小的差距。