英特尔研究院副总裁、英特尔中国研究院院长宋继强

“ChatGPT这类AI大模型训练算力成本很贵,现在能有如此大的服务器算力能力企业也就那么几家。而英特尔算力云能够解决大模型训练、推理过程中所需的算力且性能比低等难题。”近日,英特尔研究院副总裁、英特尔中国研究院院长宋继强对钛媒体App等表示,巨大的智能算力需求是英特尔看到的未来重要发力点之一。

北京时间3月30日,英特尔宣布构建256个至强芯片和512个Gaudi芯片组成、用于生成式 AI 算力的英特尔开发者云,与今年英伟达GTC大会上公布的 AI 超算云服务DGX Cloud有些类似。

目前,AI 初创公司Hugging Face和Stable Diffusion已经在使用英特尔芯片,实现包含1760亿个参数的开源语言大模型BLOOMZ和深度学习文生图大模型。

这意味着,英特尔、英伟达等芯片巨头正在利用芯片+软件工具链实现 AI 基础设施——算力云服务,这是一个关键性趋势信号。长期来看,拥有服务器芯片的供应商们将与亚马逊AWS、阿里云这些云厂商产生竞合关系。

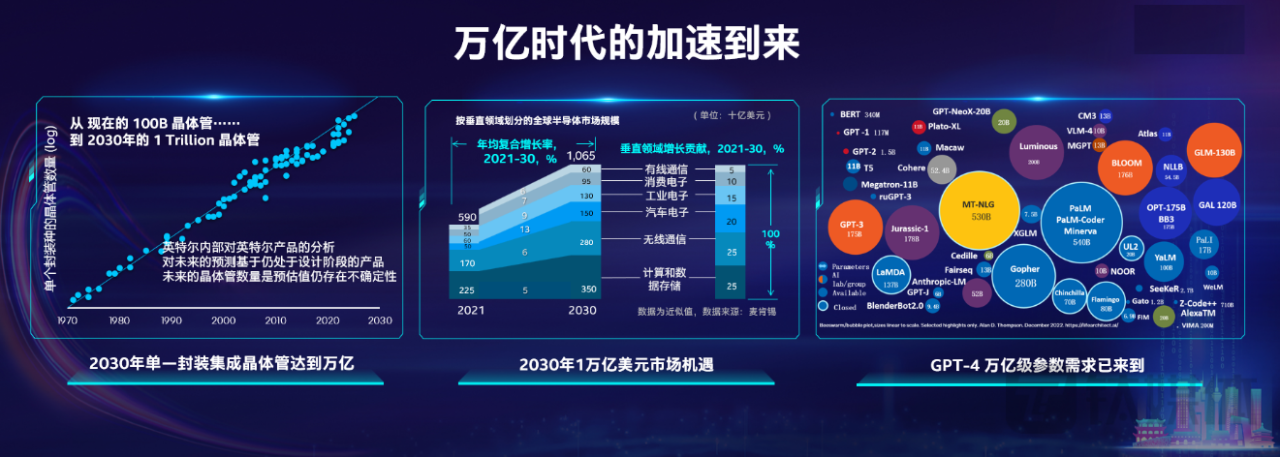

此次英特尔中国研究院、南京英麒智能科技2023探索创新日上,宋继强在主题演讲时表示,人工智能、智能计算作为数字化转型中非常重要的生产力,对于数字经济和GDP有巨大推动作用。在此背景下,三个“万亿”的时代正在加速到来:晶体管、大模型、半导体市场。

据中国信息通信研究院预计,到2032年,中国数字经济规模将超过100万亿元;英特尔预测,单个计算设备当中能够集成的晶体管数量将从现在总计1000多亿个,到2030年,单个计算设备当中可以集成1万亿个晶体管,8年有8倍的增长提升,差不多还是一个“摩尔定律”的增长速度。

“在未来包含万亿级别晶体管的大的芯片设备当中,不可能只是由英特尔一家提供芯片,所以我们未来一定是通过系统级的工艺提供产品服务,包括生产晶圆,同时也有先进封装的技术,而且还能够把不同厂商的芯粒组装在一起,达到最好的性能,最后通过软件工具还有软件的性能库让它发挥最大的作用。”宋继强再次阐述英特尔 IDM 2.0 战略,真正扩大内部工厂网络和外部芯片代工合作,帮其他厂商生产制造先进制程或成熟制程的芯片。

对于英特尔中国研究院内部,去年其更新了研究组合,新增了人类和人工智能交互协作、RISC-V敏捷开发研究等。

目前,英特尔中国研究院的八大研究领域包括:视觉智能与视觉合成、人类和人工智能交互协作、未来服务器、智能边缘、神经拟态计算、机密计算、独特IP(知识产权)&平台、RISC-V。

宋继强表示,相对于其他机构,英特尔中国研究院坚持走双轮驱动的技术研发战略,既要创新领域探索,也要规模化商业化导向,希望这些技术方案未来能够导向到产品化、大规模商用。而且,英特尔中国研究院还与国内地方政府、产业界和学术界联合起来研究科技创新,构造一个大的、在中国本地可以很好地运行的合作创新链条。

工信部数据显示,截至2022年6月,中国算力总规模超过150EFlops(每秒15000京次浮点运算次数),仅次于美国排名全球第二,在全球算力分布中占比26%。近5年,中国算力总规模年均增速超过25%。据IDC预测,未来5年,中国智能算力规模的年复合增长率将达52.3%。

随着ChatGPT热潮引发中国日益增长的 AI 算力需求,英特尔正在提前联合布局未来技术,本土驱动半导体创新。

此外,宋继强对钛媒体App表示,英特尔内部非常关注数字人技术应用,基于算力,英特尔可能会偏向于三维的超逼真效果数字人研究。他还再次强调持续支持开源RISC-V指令集架构研发,尤其在软件、IP核层面做技术积累。“不论在设备端还是边缘端,若市场的需求量很大,英特尔便可以通过代工业务进入这一领域。”

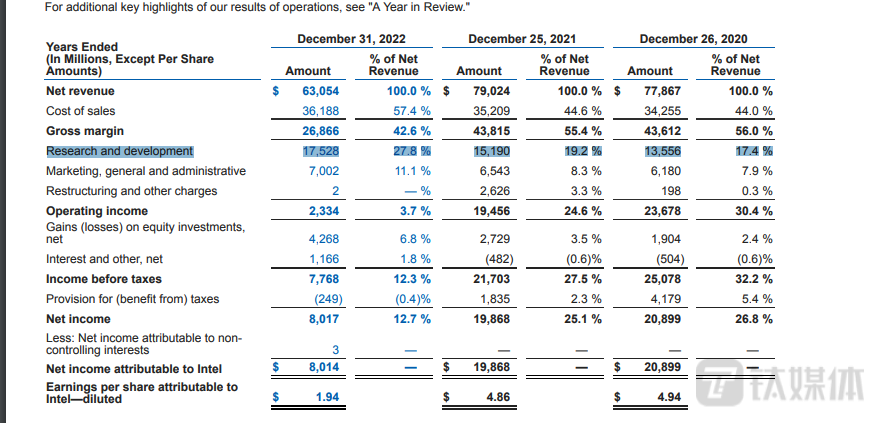

财报显示,2022年全年,英特尔研发投入达到175.28亿美元,占总收入比重的27.8%,远高于苹果(2022年研发支出77.09亿美元)、英伟达(73.39亿美元)等硅谷科技巨头,是美国科技企业里面研发支出最高的公司之一。(本文首发钛媒体App,作者|林志佳)