看过符尧大佬拆解GPT3起源的文章,收到了很多好评,同时也让我们开始思考:

1. 是否只有大模型能训出ChatGPT?

2. 小模型+精调 vs 大模型+提示词,哪个更好?Prompt已经火了一年多,然而真正在生产中应用的还是少数,我们是否真的面临范式转变?

3. 如果真需要大模型,得多大?

正好的是,符尧在ChatGPT出来之前就写过一篇深度分析大模型能力的文章,于是在我们的共同努力下把该文翻译成了中文,希望可以解答大家对大模型的一些困惑。

英文原版:

https://franxyao.github.io/blog.html

作者:符尧,yao.fu@ed.ac.uk,爱丁堡大学 (University of Edinburgh) 博士生,本科毕业于北京大学

与Tushar Khot,彭昊 在艾伦人工智能研究院 (Allen Institute for AI) 共同完成英文原稿

与 李如寐(美团NLP中心)共同翻译为中文

感谢 Aristo teammates, Jingfeng Yang, 和 Yi Tay 的讨论与建议。

请同时参考CoT[1]团队的博客。

最近,人们对大型语言模型所展示的强大能力(例如思维链[2]、便签本[3])产生了极大的兴趣,并开展了许多工作。我们将之统称为大模型的突现能力[4],这些能力可能只存在于大型模型中,而不存在于较小的模型中,因此称为“突现”。其中许多能力都非常令人印象深刻,比如复杂推理、知识推理和分布外鲁棒性,我们将在后面详细讨论。值得注意的是,这些能力很接近 NLP 社区几十年来一直寻求的能力,因此代表了一种潜在的研究范式转变,即从微调小模型到使用大模型进行上下文学习。对于先行者来说,范式转变可能是很显然的。然而,出于科学的严谨性,我们确实需要非常明确的理由来说明为什么人们应该转向大型语言模型,即使这些模型昂贵、难以使用,并且效果可能一般。在本文中,我们将仔细研究这些能力是什么,大型语言模型可以提供什么,以及它们在更广泛的 NLP/ML 任务中的潜在优势是什么。

前提:我们假设读者具备以下知识:

预训练、精调、提示(普通从业者应具备的自然语言处理/深度学习能力)

思维链提示、便签本(普通从业者可能不太了解,但不影响阅读)

一、存在于大模型而非小模型的突现能力

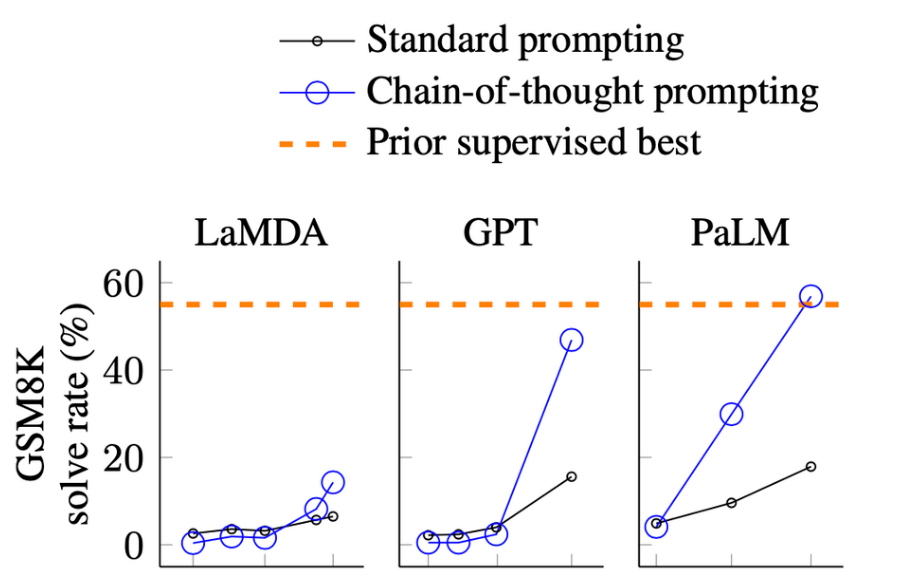

图片来自于 Wei. et. al. 2022. Chain-of-Thought Prompting Elicits Reasoning in Large Language Models。X轴为模型尺寸。GSM8K是一个小学水平的数学问题集。

在以上的效果图中,我们可以观察到模型的表现:

当尺寸相对小的时候提升并不大

当模型变大时有很明显的提升

这从根本上说明,某些能力可能不存在于小模型中,而是在大模型中获得的。

有很多种突现能力,比如 Wei 等人在 2022年[5]所梳理的。有些能力很有意思,但我们在本文不会讨论,比如last latter concatenation,我们认为这是Python而不是语言模型要做的任务;或者3位数加法,我们认为这是计算器而不是语言模型要做的事。

在本文中,我们主要对以下能力感兴趣:

1. NLP 社区近几年都关注但还没实现的能力

2. 之前的 NLP 模型很难达到的能力

3. 源自于人类语言最深层的本质的能力

4. 可能达到人类智力的最高水平的能力